Оптимизация ИИ-инфраструктуры: стратегия физического разделения моделей

- Джимшер Челидзе

- 8 авг. 2025 г.

- 3 мин. чтения

В последние годы многие компании осознают, что искусственный интеллект перестал быть экспериментальной технологией и стал реальным инструментом конкурентного преимущества. При этом далеко не все готовы строить собственные облачные ИИ-платформы — будь то из-за требований информационной безопасности, рисков утечки данных, высокой стоимости облачных ресурсов или необходимости полного контроля над инфраструктурой. Всё чаще бизнес ищет локальные, автономные решения, работающие внутри корпоративного периметра.

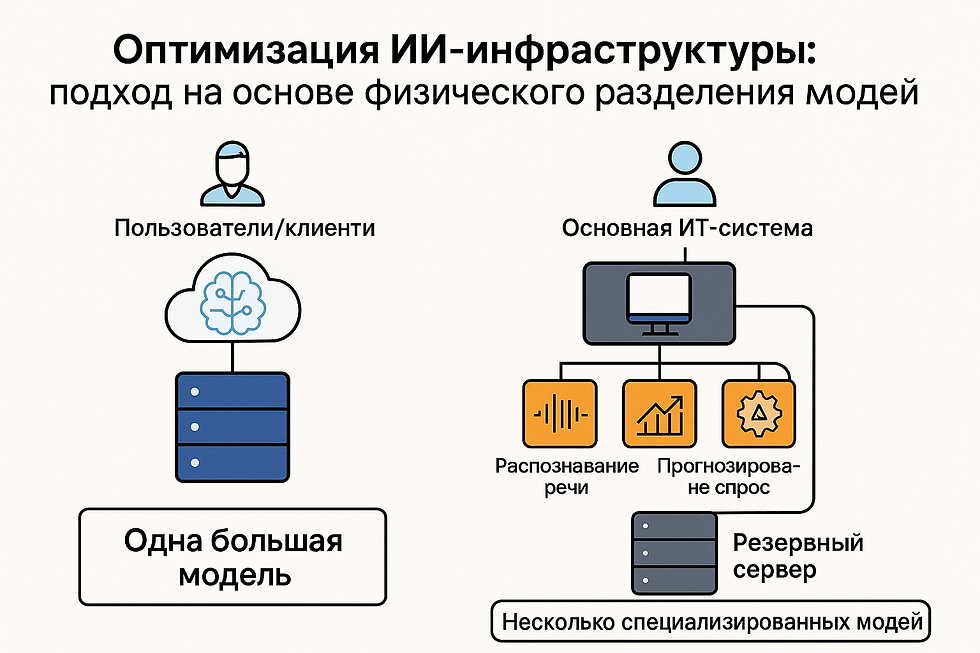

Поэтому бизнес всё чаще делает выбор в пользу локальных, автономных ИИ-решений, работающих внутри корпоративного периметра и с внутренними базами данными / документами. И здесь встаёт ключевой вопрос: строить систему по традиционной схеме — на одном мощном сервере с одной универсальной большой моделью, или внедрять современную модульную архитектуру, в которой несколько специализированных моделей работают независимо?

Мы продвигаем второй подход — создание набора ИИ-моделей среднего размера (20–30 млрд параметров), каждая из которых оптимизирована под конкретную прикладную задачу. Эти модели разворачиваются на выделенных серверных «островках» с оптимальной конфигурацией оборудования. Такой подход сочетает масштабируемость, точную настройку под задачу, устойчивость к сбоям, прозрачный контроль затрат и высокий уровень безопасности.

Архитектурный принцип: специализированные «островки» для каждой задачи

Стратегия предполагает следующий порядок развертывания ИИ-решений:

Идентификация бизнес-задачи — определение конкретной операционной или стратегической задачи, где применение ИИ даёт измеримую ценность (анализ клиентских настроений, предиктивное обслуживание оборудования, автоматизация поддержки, оптимизация цепочек поставок).

Выделение серверного ресурса — под выбранную задачу и модель выделяется отдельный физический сервер или высокоизолированная виртуальная машина с гарантированными ресурсами (CPU, GPU, RAM, storage).

Точная конфигурация под цель — оборудование настраивается исключительно исходя из требований модели и профиля нагрузки.

Изолированное выполнение — модель работает в собственной среде, не влияя на другие ИИ-компоненты, при этом сохраняя необходимые интерфейсы для интеграции.

Схема архитектуры

Ключевые преимущества

Повышенная эффективность и упрощённое масштабирование

Оптимизация ресурсов за счёт точного подбора конфигураций под каждую задачу.

Отсутствие конкуренции за вычислительные мощности между моделями.

Масштабирование только нужного «островка» при росте нагрузки.

Изолированное обновление и замена моделей без риска для других систем.

Прозрачность финансовой модели и ROI

Чёткая атрибуция затрат на оборудование и поддержку к конкретной задаче.

Измерение эффективности в привязке к бизнес-метрикам.

Возможность точного расчёта возврата на инвестиции.

Пример расчёта ROI

Экономия от прогнозирования поломок оборудования — 5 000 000 ₽/год.

Годовое содержание сервера — 200 000 ₽.

Интеграция и разработка — 3 000 000 ₽ (единовременно).

Шаг 1. Годовая выгода = 5 000 000 − 200 000 = 4 800 000 ₽.

Шаг 2. ROI первого года = (4 800 000 − 3 000 000) / 3 000 000 × 100%= (1 800 000 / 3 000 000) × 100% ≈ 60%.

Вывод: проект окупается за первый год и уже в первый же год приносит положительный финансовый результат, при этом последующие годы дают чистую экономию порядка 4,8 млн ₽ ежегодно.

Усиление информационной безопасности

Изоляция данных и вычислительных процессов между задачами.

Детализированное управление доступом по принципу минимальных привилегий.

Сокращение атакуемой поверхности: взлом одного сервера не скомпрометирует всю систему.

Локализация обработки данных облегчает соответствие GDPR, CCPA, 152-ФЗ и другим нормам.

Повышение отказоустойчивости

Локализация инцидентов: сбой одного «островка» затрагивает только его функцию.

По статистике, около 3% серверов выходят из строя ежемесячно; при модульной архитектуре это не парализует всю платформу.

Быстрое восстановление с помощью резервного сервера (стратегия N+1).

Управляемые сложности

Необходимость зрелых DevOps-практик и инструментов оркестрации (например, Kubernetes).

Риск недоиспользования ресурсов при переменной нагрузке — решается виртуализацией и контейнеризацией.

Более высокие стартовые инвестиции, но более низкая совокупная стоимость владения (TCO) в перспективе.

Возможная сетевая задержка при частом межмодельном обмене — требуется быстрый сетевой контур.

Оптимальные сценарии применения

Критически важные бизнес-процессы.

Обработка чувствительных данных.

Модели с разнородными требованиями к ресурсам.

Проекты с жёсткими требованиями к прозрачности затрат и ROI.

Интеграция с legacy-системами, где единая ИИ-платформа затруднена.

Альтернативные подходы

Облачные GPU/TPU-сервисы — гибкость и скорость развертывания, но вопросы безопасности и зависимости от вендора.

Kubernetes-кластеры с поддержкой AI/ML — баланс изоляции и эффективного использования ресурсов, требующий высокой экспертизы.

Заключение

Физическое разделение ИИ-моделей на выделенные серверы — это не просто техническое решение, а стратегический выбор. Оно обеспечивает управляемость, безопасность, отказоустойчивость и прозрачность затрат. Для организаций, где критичны надёжность, защита данных и экономическая обоснованность ИИ-инициатив, такая архитектура становится оптимальной.